INTRUDUCCION.

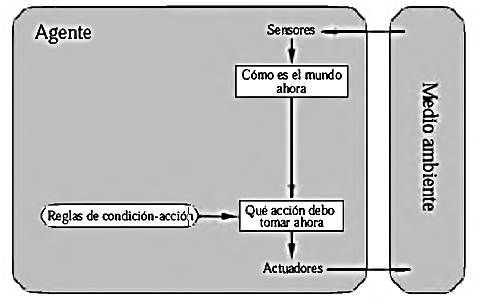

El siguiente tema a revisar tomaremos en cuenta la estructura

de la que dispone un agente racional, se tomara en cuenta mediante qué forma

realiza sus acción incluyendo gráficos en los que se logra manifestar lo que se

está tratando.

Si ya bien sabemos la estructura de un agente reacciona

dependiendo de su medio o entorno esto se toma en cuenta como percepción por

medios sensoriales. Y a continuación nuestro tema.

ESTRUCTURA

DE LOS AGENTES.

Este se trata de centrarse en el núcleo del problema y

hablar sobre cómo trabajan internamente. El trabajo de la IA es diseñar el

programa del agente implemente la función del agente que proyecta las

percepciones en las acciones. Se asume que este programa se ejecutara en algún

tipo de computador con sensores físicos y actuadores, lo cual se conoce

como arquitectura:

Agente = arquitectura + programa

Obviamente, el programa que se elija tiene que ser

apropiado para la arquitectura. Si el programa tiene que recomendar acciones

como Caminar, la arquitectura tiene que tener piernas. La arquitectura puede

ser un PC común, o puede ser un coche robotizado con varios computadores,

cámaras, y otros sensores a bordo. En general, la arquitectura hace que las

percepciones de los sensores estén disponibles para el programa.

PROGRAMAS DE LOS AGENTES.

Los programas de los agentes reciben las percepciones

actuales como entradas de los sensores y devuelven una acción a los actuadores.

Hay que tener en cuenta la diferencia entre los programas de los agentes, que

toman la percepción actual como entrada, y la función del agente, que recibe la

percepción histórica completa.

El desafío clave de la IA es encontrar la forma de

escribir programas, que en la medida de lo posible, reproduzcan un

comportamiento racional a partir de una pequeña cantidad de código en vez de a

partir de una tabla con un gran número de entradas.

En lo que resta de esta sección se presentan los cuatro

tipos básicos de programas para agentes que encarnan los principios que

subyacen en casi todos los sistemas inteligentes.

• Agentes reactivos simples.

• Agentes reactivos basados en modelos.

• Agentes basados en objetivos.

• Agentes basados en utilidad.

Despues de los siguientes se dara a conocer los agentes que aprenden.

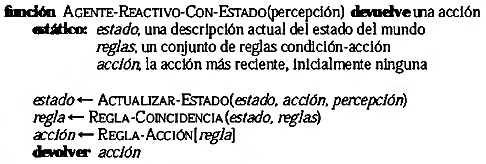

AGENTES

REACTIVOS SIMPLES.

El tipo de agente más sencillo es el agente reactivo simple Estos agentes seleccionan Las acciones sobre la base de las percepciones actuales, ignorando el resto de las percepciones Históricas. Por ejemplo, el agente aspiradora cuya función de agente se presentó un agente reactivo simple porque toma sus decisiones solo con base en la localización actual y si esta está sucia.

AGENTES

REACTIVOS BASADOS EN MODELOS.

La forma más efectiva que tienen los agentes de manejar

la visibilidad parcial es almacenar información de las partes del mundo que no

pueden ver. O lo que es lo mismo, el agente debe mantener algún tipo de estado

interno que dependa de la historia percibida y que de ese modo refleje por lo

menos alguno de los aspectos no observables del estado actual.

La actualización de la información de estado interno según

pasa el tiempo requiere codificar dos tipos de conocimiento en el programa del

agente. Primero, se necesita alguna información acerca de cómo evoluciona el

mundo independientemente del agente. Segundo, se necesita más información sobre

cómo afectan al mundo las acciones del agente.

Este conocimiento acerca de (cómo funciona el mundo), tanto si esta implementado con un circuito booleano simple o con teorías científicas completas, se denomina modelo del mundo. Un agente que utilice este modelo es un agente basado en modelos.

AGENTES BASADOS EN OBJETIVOS.

El conocimiento sobre el estado actual del mundo no es

siempre suficiente para decidir qué hacer. Por ejemplo, en un cruce de

carreteras, el taxista puede girar a la izquierda, girar a la derecha o seguir

hacia adelante. La decisión correcta depende de dónde quiere ir el taxi. En

otras palabras, además de la descripción del estado actual, el agente necesita

algún tipo de información sobre su meta que describa las situaciones que son

deseables, por ejemplo, llegar al destino propuesto por el pasajero. El

programa del agente se puede combinar con información sobre los resultados de

las acciones posibles (la misma información que se utilizó para actualizar el

estado interno en el caso del agente reflexivo) para elegir las acciones que

permitan alcanzar el objetivo. En algunas ocasiones,

la selección de acciones basadas en objetivos es directa, cuando alcanzar los

objetivos es el resultado inmediato de una acción individual. En otras

ocasiones, puede ser más complicado, cuando el agente tiene que considerar

secuencias complejas

Para encontrar el camino que le permita alcanzar el

objetivo.

AGENTES BASADOS EN UTILIDAD.

Las metas por si solas no son realmente suficientes para

generar comportamiento de gran calidad en la mayoría de los entornos. Por

ejemplo, hay muchas secuencias de acciones que llevaran al taxi a su destino (y

por tanto a alcanzar su objetivo), pero algunas son más rápidas, más seguras,

más fiables, o más baratas que otras. Las metas solo proporcionan una cruda

distinción binaria entre los estados de (felicidad) y (tristeza), mientras que

una medida de eficiencia más general debería permitir una comparación entre

estados del mundo diferentes de acuerdo al nivel exacto de felicidad que el

agente alcance cuando se llegue a un estado u otro.

Una función de utilidad proyecta un estado (o una secuencia de estados) en un número real, que representa un nivel de felicidad. La definición completa de una función de utilidad permite tomar decisiones racionales en dos tipos de casos en los que las metas son inadecuadas. Primero, cuando haya objetivos conflictivos, y solo se puedan alcanzar algunos de ellos (por ejemplo, velocidad y seguridad), la función de utilidad determina el equilibrio adecuado. Segundo, cuando haya varios objetivos por los que se pueda guiar el agente, y ninguno de ellos se pueda alcanzar con certeza, la utilidad proporciona un mecanismo para ponderar la probabilidad de éxito en función de la importancia de los objetivos.

AGENTES QUE

APRENDEN.

Se han descrito programas para agentes que poseen varios

métodos para seleccionar acciones. Hasta ahora no se ha explicado cómo poner en

marcha estos programas de agentes. Turing (1950), en su temprano y famoso

artículo, considero la idea de programar Sus máquinas inteligentes a mano.

Estimo cuanto tiempo podía llevar y concluyo que (Sería deseable utilizar algún

método más rápido). El método que propone es construir máquinas que aprendan y

después ensenarlas. En muchas áreas de IA, este es ahora el método más adecuado

para crear sistemas novedosos. El aprendizaje tiene otras ventajas, como se ha

explicado anteriormente: permite que el agente opere en medios inicialmente desconocidos

y que sea más competente que si solo utilizase un conocimiento inicial.

Los agentes tienen una gran variedad de componentes, y

estos componentes se pueden representar de muchas formas en los programas de

agentes, por lo que, parece haber una gran variedad de métodos de aprendizaje.

Existe, sin embargo, una visión unificada sobre un tema fundamental. El aprendizaje

en el campo de los agentes inteligentes puede definirse como el proceso de modificación

de cada componente del agente, lo cual permite a cada componente comportarse más

en consonancia con la información que se recibe, lo que por tanto permite

mejorar el nivel medio de actuación del agente.

CONCLUCION.

En

conclusión vemos como obviamente las estructuras se concentran en los problemas

que disponen los medios para que estos sean resueltos por medio de las acciones

realizadas de los agentes, esto se logra dar gracias a los sensores que

permiten la percepción y los actuadores que permiten q se logre la acción que

se requiere realizar.

BIBLIOGRAFIA.

Russell, S; Norvig P. 2004. Inteligencia Artificial Un

Enfoque Moderno, Segunda Edición.

Corchado, J. Modelos y Arquitectura de Agentes. Formato

PDF. Disponible en: http://bisite.usal.es/archivos/c1%20(1).pdf

No hay comentarios.:

Publicar un comentario